Creación de Pipelines ETL con Python

José Rafael Gutierrez

hace 1 año

Introducción

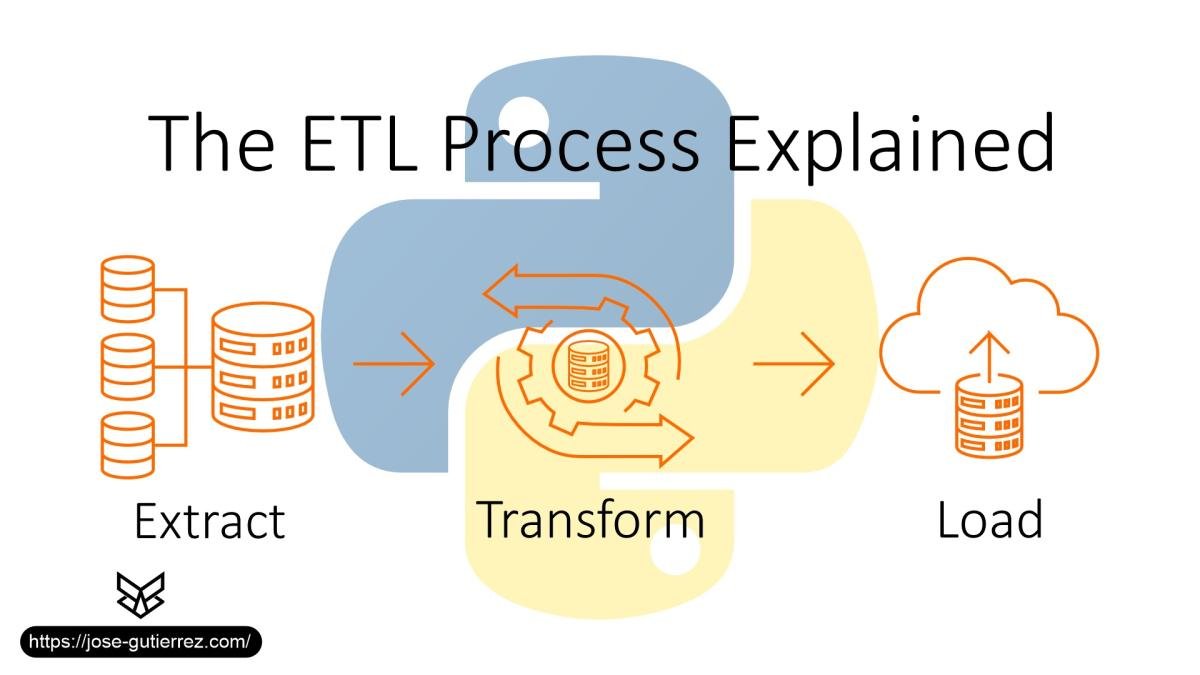

En la ingeniería de datos, los pipelines ETL (Extract, Transform, Load) son esenciales para recopilar y procesar datos de múltiples fuentes y cargarlos en una base de datos de destino. Un pipeline ETL efectivo ayuda a limpiar, estructurar y transformar datos en bruto en un formato que proporciona información valiosa. En este artículo, mostraremos cómo construir un pipeline ETL utilizando Python y bibliotecas como pandas, SQLAlchemy y Airflow, aplicando prácticas recomendadas y principios de código limpio para garantizar legibilidad, eficiencia y escalabilidad.

Exploraremos cada paso del proceso ETL con casos de uso reales, desde la extracción de datos, transformación con Python y pandas, hasta la carga en una base de datos SQL.

Secciones

- Comprender los Pipelines ETL y Su Importancia

- Configurar el Entorno

- Extraer Datos de las Fuentes

- Transformar Datos Usando Pandas

- Cargar Datos en una Base de Datos

- Automatizar el Proceso ETL con Airflow

- Mejores Prácticas y Principios de Código Limpio para ETL

1. Comprender los Pipelines ETL y Su Importancia

Un pipeline ETL es un flujo de trabajo que procesa datos en tres etapas:

- Extract (Extracción): Los datos se recopilan de diversas fuentes, como bases de datos, APIs o archivos (como CSV o JSON).

- Transform (Transformación): Los datos en bruto se limpian, normalizan y transforman para adaptarse a la estructura y necesidades de la base de datos de destino.

- Load (Carga): Los datos transformados se cargan en una base de datos de destino o data warehouse para análisis o informes posteriores.

Los pipelines ETL son esenciales en las empresas para gestionar datos de múltiples sistemas de manera eficiente, asegurando la consistencia, disponibilidad y fácil acceso a los datos para los equipos de análisis.

2. Configurar el Entorno

Para seguir este artículo, asegúrate de tener Python instalado junto con las bibliotecas necesarias. Necesitarás:

- pandas: Para transformación y manipulación de datos.

- SQLAlchemy: Para conectarse e interactuar con bases de datos SQL.

- Airflow: Para automatizar y programar el pipeline ETL.

Instala estas dependencias a través de pip:

pip install pandas sqlalchemy apache-airflow

3. Extraer Datos de las Fuentes

Escenario Ejemplo: Extracción de Datos de un Archivo CSV

En este ejemplo, extraeremos datos de un archivo CSV que contiene información de productos. Supongamos que los datos están en un archivo llamado productos.csv.

Código para Extraer Datos

import pandas as pd

# Extraer datos de CSV

def extract_data(file_path):

try:

data = pd.read_csv(file_path)

print("¡Extracción de datos exitosa!")

return data

except Exception as e:

print(f"Error al extraer datos: {e}")

return None

# Ejemplo de uso

file_path = 'productos.csv'

raw_data = extract_data(file_path)

Explicación:

-

Función de Extracción: Definimos la función

extract_dataque lee los datos desde la ruta de archivo especificada. - Manejo de Errores: Como práctica de código limpio, utilizamos manejo de errores para capturar problemas como archivos faltantes o formatos incorrectos.

Esta función extrae los datos en bruto, listos para el siguiente paso en el pipeline: transformación.

4. Transformar Datos Usando Pandas

Limpiar y Normalizar Datos

En este paso de transformación, limpiaremos y normalizaremos los datos. Supongamos que nuestros datos en bruto contienen algunos campos con valores faltantes o formatos inconsistentes, que limpiaremos usando pandas.

Código de Transformación

def transform_data(data):

# Eliminar filas con valores nulos

data.dropna(inplace=True)

# Normalizar columnas de texto a minúsculas

data['nombre_producto'] = data['nombre_producto'].str.lower()

# Convertir el precio a un formato numérico

data['precio'] = pd.to_numeric(data['precio'], errors='coerce')

# Asegurar que no haya precios negativos

data = data[data['precio'] >= 0]

print("¡Transformación de datos exitosa!")

return data

# Transformar los datos en bruto

cleaned_data = transform_data(raw_data)

Explicación:

- Manejo de Valores Nulos: Eliminamos filas con valores faltantes.

- Normalización de Texto: Convertimos los campos de texto a minúsculas para mantener la consistencia.

- Conversión de Tipos de Datos: Convertimos la columna de precios a un tipo numérico para facilitar cálculos futuros.

- Validación de Datos: Eliminamos filas con precios negativos para garantizar la integridad de los datos.

Práctica Recomendada: Organizar las transformaciones en pasos individuales y legibles facilita el mantenimiento del código y su depuración.

5. Cargar Datos en una Base de Datos

Configurar una Conexión a la Base de Datos con SQLAlchemy

Una vez que los datos están limpios, el siguiente paso es cargarlos en una base de datos. En este ejemplo, usaremos SQLAlchemy para cargar los datos en una base de datos MySQL.

Código de Conexión a la Base de Datos

from sqlalchemy import create_engine

# Conectar a la base de datos MySQL

def get_db_connection():

try:

engine = create_engine("mysql+mysqlconnector://usuario:contraseña@localhost/nombre_bd")

print("¡Conexión a la base de datos exitosa!")

return engine

except Exception as e:

print(f"Error en la conexión a la base de datos: {e}")

return None

# Insertar datos en MySQL

def load_data(data, engine):

try:

data.to_sql('productos', con=engine, if_exists='replace', index=False)

print("¡Datos cargados exitosamente!")

except Exception as e:

print(f"Error al cargar datos: {e}")

# Ejemplo de uso

engine = get_db_connection()

if engine:

load_data(cleaned_data, engine)

Explicación:

-

Conexión a la Base de Datos: La función

get_db_connectionestablece una conexión con la base de datos usando SQLAlchemy. -

Carga de Datos: La función

load_datacarga los datos en la tablaproductos, reemplazándola si ya existe.

Nota de Seguridad: Usa variables de entorno o un gestor de contraseñas para las credenciales en entornos de producción.

6. Automatizar el Proceso ETL con Airflow

Con Apache Airflow, podemos automatizar el pipeline ETL, asegurando que se ejecute en un horario específico o en respuesta a eventos. Airflow nos permite definir flujos de trabajo como grafos acíclicos dirigidos (DAGs).

Ejemplo de un DAG de Airflow para ETL

Este ejemplo muestra un DAG básico en Airflow que ejecuta los pasos extract, transform y load.

Código para el DAG en Airflow

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from datetime import datetime

# Definir DAG

dag = DAG(

'pipeline_etl',

description='Pipeline ETL usando Python y Airflow',

schedule_interval='@daily',

start_date=datetime(2023, 1, 1),

catchup=False,

)

# Tareas en Airflow

extract_task = PythonOperator(

task_id='extract_data',

python_callable=extract_data,

op_kwargs={'file_path': 'productos.csv'},

dag=dag,

)

transform_task = PythonOperator(

task_id='transform_data',

python_callable=transform_data,

op_kwargs={'data': raw_data},

dag=dag,

)

load_task = PythonOperator(

task_id='load_data',

python_callable=load_data,

op_kwargs={'data': cleaned_data, 'engine': engine},

dag=dag,

)

# Dependencias entre tareas

extract_task >> transform_task >> load_task

Explicación:

-

Definición del DAG: El objeto DAG define el pipeline ETL y su programación (

@daily). -

Tareas: Definimos cada paso del pipeline ETL (

extract_data,transform_data,load_data) como unPythonOperator. - Dependencias: Cada tarea depende de la anterior, creando un flujo lineal desde la extracción hasta la carga.

Ejecutar el DAG

Inicia Airflow y ejecuta el DAG desde la interfaz de Airflow para ver el pipeline ETL automatizado en acción.

7. Mejores Prácticas y Principios de Código Limpio para ETL

7.1 Principios de Código Limpio

- Modularización: Separa cada paso (extract, transform, load) en funciones independientes para hacer el código reutilizable y fácil de mantener.

- Manejo de Errores: Implementa manejo de errores en

cada función para capturar y registrar problemas, mejorando la confiabilidad.

- Documentación: Documenta cada función con comentarios para mejorar la legibilidad y comprensión.

7.2 Mejores Prácticas para Pipelines ETL

- Validación de Datos: Siempre valida los datos en el paso de transformación para evitar inconsistencias en la base de datos final.

- Credenciales Seguras: Usa variables de entorno para las credenciales de la base de datos para mejorar la seguridad.

- Monitorización de Trabajos ETL: Monitorea regularmente el rendimiento del pipeline ETL usando herramientas como los registros de Airflow y Grafana para identificar cuellos de botella.

- Optimizar la Carga de Datos: Usa procesamiento por lotes si trabajas con grandes volúmenes de datos para mejorar los tiempos de carga en la base de datos.

Al seguir estos principios, creamos un pipeline ETL limpio, eficiente y escalable que es más fácil de depurar y mantener a lo largo del tiempo.

Conclusión

Construir un pipeline ETL en Python requiere una planificación cuidadosa, modularización y adherencia a los principios de código limpio para garantizar la eficiencia y escalabilidad. En esta guía, utilizamos bibliotecas de Python como pandas y SQLAlchemy para procesar datos y automatizar flujos de trabajo con Airflow. Este enfoque modular es ideal para ingenieros de datos que gestionan pipelines, ya que asegura la calidad constante de los datos y reduce la sobrecarga operativa.

Con las habilidades adquiridas en esta guía, estás equipado para construir pipelines ETL robustos que escalen con las necesidades del negocio y mantengan la integridad de los datos, haciendo que los insights valiosos estén disponibles para los responsables de la toma de decisiones.